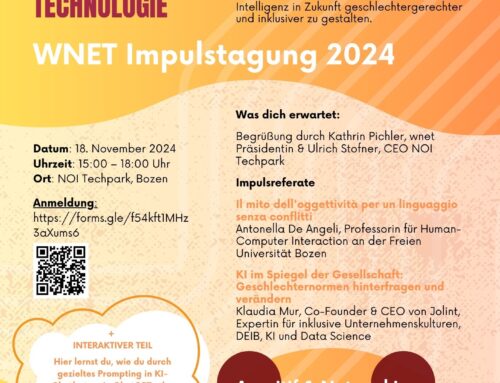

Künstliche Intelligenz (KI) ist längst in unserem Alltag angekommen. Sie beeinflusst Entscheidungsprozesse im Finanzsektor, in der Diagnose und Früherkennung im Gesundheitswesen, in der Personalauswahl in Unternehmen bis hin zur kreativen Text- und Bildgenerierung. Doch KI ist keineswegs neutral, sondern ist geprägt von gesellschaftlichen Normen und häufig von unzureichenden und unausgewogenen Datensätzen, was zu Verzerrungen der Realität (Bias) führt. Welche Folgen das hat und wie man gegensteuern kann, war das Thema der Wnet-Impulstagung 2024 „KI ohne Bias. Wie erreicht man eine inklusive Technologie“, die in Partnerschaft mit dem Tech Transfer Unit Digital des NOI Techparks ausgetragen wurde.

Die Expertinnen Antonella De Angeli, Professorin für Human-Computer-Interaction an der Freien Universität Bozen, und Klaudia Mur, Data Scientist und Gründerin von Jolint, gingen in ihren Beiträgen auf verankerte gesellschaftliche Muster und Stereotypen in KI-Systemen ein, auf die Leistungen von KI bei der Verarbeitung von riesigen Datenmengen und den Einfluss von Kontrollorganen und Nutzerinnen auf die Qualität der Ergebnisse.

Automatische Sprachsysteme, einen Teilaspekt der KI, behandelte Prof. Antonella De Angeli in ihrem Vortrag „Der Mythos der Objektivität für eine konfliktfreie Sprache“. Automatischen Systemen zur Generierung natürlicher Sprache wird die Prämisse der Neutralität zugrunde gelegt. Die Maschine neigt dazu, keine Position zu beziehen und versucht auf jede erdenkliche Weise, Konflikte zu vermeiden, so auch die Klassifizierung von Personen auf der Grundlage sozialer Merkmale, wie zum Beispiel dem Geschlecht. So möchte man die Herausbildung von Stereotypen und Vorurteilen verhindern, mit der Gefahr, eine amorphe Realität zu schaffen, die unvermeidlich mit der menschlichen Wahrnehmung in Konflikt gerät. Den Sprachsystemen (Maschinen) werden menschliche Eigenschaften zugeschrieben, da sie immer freundlich auf Anweisungen reagieren, siehe Chatbot (Virtueller Assistent). Diese Anthropomorphisierung kann das Vertrauen und die Akzeptanz in die Technologie steigern, birgt aber auch Risiken, da die Nutzer den Maschinen Eigenschaften zuschreiben, die sie tatsächlich nicht besitzen, was zu Missverständnissen und falschen Erwartungen und auch falschen Entscheidungen mit entsprechenden Folgen führen kann. Verzerrungen in den Sprachmodellen können über die Kontrolle der Datensätze bei OpenIA vermieden bzw. reduziert werden. KI ist geeignet große Datenmenge schnell zu verarbeiten, Muster schnell zu erkennen und Routineprozesse schnelle auszuführen. Kreative Prozesse finden auf einer anderen Zeitskala statt und brauchen Rückmeldungen, so das Fazit von Antonella De Angeli.

Klaudia Mur betonte, dass KI aufgrund der verwendeten Datensätze oft ein bestimmtes Ideal von Mensch und Gesellschaft widerspiegelt: jung weiß, christlich, gut aussehend, Familienkonstellation bestehend aus Mann, Frau und 2 Kindern. Als Expertin für inklusive Unternehmenskultur, KI und Data Science, erhofft sie sich von der KI eine gerechtere Gesellschaft und eine diversere und inklusivere Tech-Branche. In ihrem Vortrag „KI im Spiegel der Gesellschaft: Geschlechternormen hinterfragen und verändern“ verwies sie darauf, dass technologische Entwicklungen nie losgelöst von gesellschaftlichen Strukturen stattfinden und somit nicht neutral sind. Das gilt auch für die generative KI, also ChatGPT oder andere Modelle für die Erstellung von Texten und Bildern. Generative KI wird an Datensätzen trainiert, die zum Teil sexistisch sind, Verzerrungen in sich tragen und folglich gesellschaftliche Ungleichheiten widerspiegeln bzw. sie unbewusst verstärken, da meistens Männer an ihrer Entwicklung arbeiten. Einen weiteren Einfluss auf eine mehr oder wenigere Verzerrung der Realität haben die an Testprozessen beteiligten Personen und die Endnutzerinnen und Endnutzer.

Anhand von Claudia Mur moderierten praktischen Übungen an mitgebrachten Leptops konnten die über 60 Teilnehmerinnen und Teilnehmer direkt erfahren wie KI bestehende Diskriminierungen und normative Strukturen weiterträgt. Die Anfrage nach einer „Südtiroler Familie“ lieferte stereotypische Darstellungen mit Alpenkulisse, Trachten und Kleinfamilien. Unternehmerinnen wurden in sozialen Berufen dargestellt, während männliche Unternehmer in wirtschaftlichen Kontexten erschienen. Durch gezielte Anweisungen an KI-Chatbots wie ChatGPT oder Google Gemini haben Menschen die Möglichkeit, diese Verzerrungen zu beeinflussen und eine vielfältigere Darstellung der Realität zu erzielen.

Was können Frauen tun, um etwas zu verändern!

KI bietet einen niederschwelligen Zugang zu Wissen und Fähigkeiten und somit einen einfacheren Zugang zu Technologien. Damit KI geschlechtergerechter und inklusiver wird, müssen Frauen und unterrepräsentierte Menschen sich einbringen und KI aktiv mitgestalten und weiterentwickeln. Auf der anderen Seite müssen Tech-Unternehmen diverser und inklusiver werden. Nur in der Hand von vielen wird irgendwann KI auch unsere Gesellschaft besser widerspiegeln und helfen, gesellschaftliche Normen zu verbessern bzw. zu ändern, so die Überzeugung von Klaudia Mur.

Der zuständige Landesrat für Innovation, Wirtschaft und Bildung Philipp Achammer hatte seine Grußworte über eine Videobotschaft geschickt. Er sieht die Entwicklungen in der KI aus einer wachsamen Position heraus. KI kann entlasten, aber es braucht Transparenz zu den zugrunde liegenden Datensätzen. Die Unterscheidung zwischen Fakten und künstlichen und absichtlich falschen bzw. irreführenden Informationen wird zunehmend schwieriger. Die verfassungsmäßig garantierten Freiheiten und Grundwerte dürfen bei KI-Anwendungen keine Abstriche erfahren.

NOI-Direktor Ulrich Stofner betonte, dass der NOI Techpark die zentrale Anlaufstelle für technologische Innovationen rund um KI ist. Umso wichtiger ist es, neben den Möglichkeiten der KI auch ihre ethischen Auswirkungen zu berücksichtigen und in den Diskurs miteinzubauen.

Für Wnet-Präsidentin Kathrin Pichler machte die Veranstaltung mehr als deutlich, wie subtil gesellschaftliche Vorurteile in KI-Systeme einfließen, aber auch welche Möglichkeiten bestehen, die KI anzuhalten, die Gesellschaft in ihrer Vielfalt besser darzustellen.

Teilnehmerinnen und Teilnehmer bei der praktischen Übung mit KI

Von links: Wnet-Präsidentin Kathrin Pichler, Klaudia Mur, Prof.ssa Antonella De Angeli, Leiter Tech Transfer Unit Digital NOI Techpark Patrick Ohnewein, Wnet-OrgateamMarlene Rinner, Wnet-Orgateam und Moderatorin Sandra Kainz

Links zu Interviews mit Klaudia Mur auf Rai Südtirol und Salto:

RAI Südtirol NEWS 19.11.2024

RAI Mittagsmagazin 19.11.2024, ab Minute 17:44

https://www.raibz.rai.it/podcast/deu/mittagsmagazin/mittagsmagazin.xml

SALTO 15.11.2024

https://salto.bz/de/article/15112024/es-braucht-mehr-frauen

Erstellt von Marlene Rinner